1. Introducción: ¿Qué es la Inteligencia Artificial?

- 1.1. Definiendo la IA: Más allá de la ciencia ficción, ¿qué significa realmente “inteligencia artificial”?

- Sistemas que simulan procesos de inteligencia humana (aprendizaje, razonamiento, percepción).

- Tipos de IA:

- IA Débil (ANI – Artificial Narrow Intelligence): Diseñada para una tarea específica (ej., jugar ajedrez, reconocer caras).

- IA Fuerte (AGI – Artificial General Intelligence): Capacidades intelectuales humanas. (Aún en desarrollo, es el objetivo a largo plazo).

- Superinteligencia Artificial (ASI): Excede la inteligencia humana. (Hipótesis).

- 1.2. ¿Por qué es importante entender la IA hoy?

- Impacto en la vida diaria, el trabajo, la sociedad.

- Prepararse para el futuro.

2. El Corazón de la IA: Machine Learning (Aprendizaje Automático)

- 2.1. Machine Learning (ML): El “cómo” aprende la IA.

- Definición: La capacidad de los sistemas para aprender de datos sin ser programados explícitamente.

- Analogía: Enseñarle a un niño a reconocer gatos mostrándole muchas fotos de gatos y no-gatos.

- 2.2. Tipos de Aprendizaje Automático:

- Aprendizaje Supervisado:

- Definición: Aprender de datos etiquetados (pares de entrada-salida).

- Ejemplos: Clasificación (spam/no spam), Regresión (predecir precios de casas).

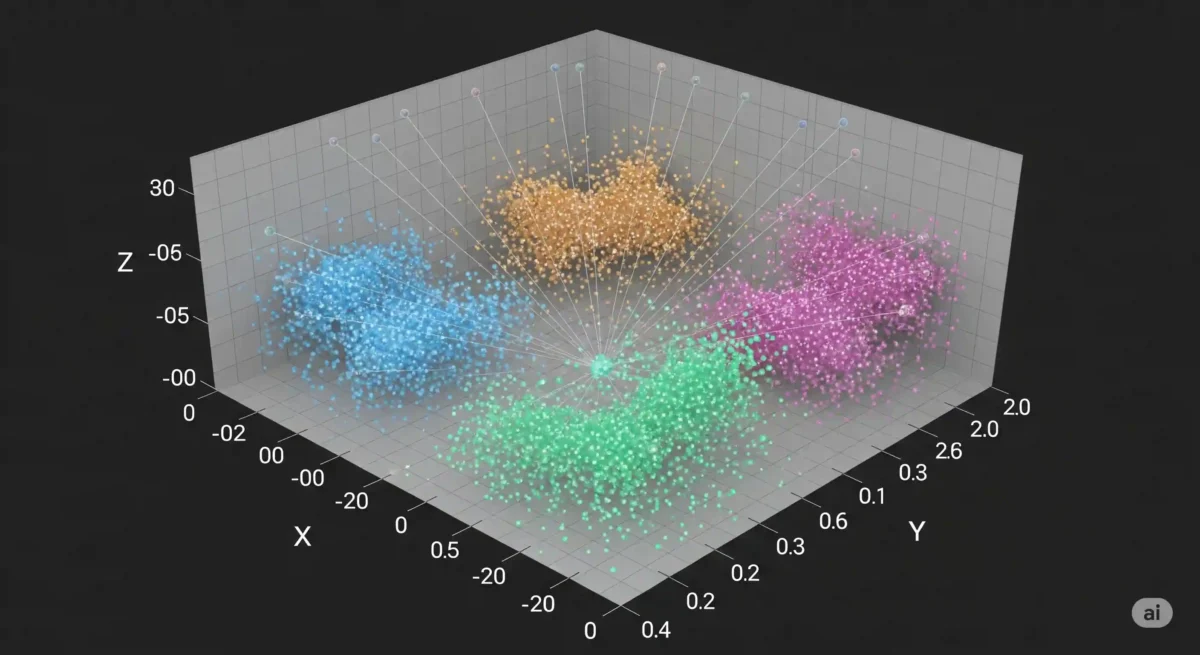

- Aprendizaje No Supervisado:

- Definición: Encontrar patrones y estructuras en datos no etiquetados.

- Ejemplos: Clustering (agrupar clientes por comportamiento), Reducción de dimensionalidad.

- Aprendizaje por Refuerzo:

- Definición: Aprender a través de la interacción con un entorno, recibiendo recompensas o penalizaciones.

- Ejemplos: Entrenar un agente para jugar un videojuego, robots que aprenden a caminar.

- Aprendizaje Supervisado:

- 2.3. Diferencias clave entre IA y Machine Learning:

- La IA es el concepto amplio de “máquinas inteligentes”.

- El Machine Learning es un subcampo de la IA y es el método principal por el cual muchas IA “aprenden”.

- Analogía: “Fruta” es IA, “manzana” es Machine Learning. No todas las frutas son manzanas, pero todas las manzanas son frutas.

3. El Lenguaje de la IA: Texto, Vectores y Embeddings

- 3.1. Procesamiento del Lenguaje Natural (PLN/NLP):

- Definición: El campo de la IA que permite a las computadoras entender, interpretar y generar lenguaje humano.

- 3.2. Tokenización: Descomponiendo el Lenguaje.

- Concepto: Dividir el texto en unidades más pequeñas llamadas “tokens”.

- Ejemplos de tokens: Palabras, subpalabras, caracteres.

- Importancia: Es el primer paso para que una máquina pueda “leer” el texto.

- 3.3. Embeddings: El Mapa del Significado.

- Problema: Las computadoras no entienden las palabras como nosotros. Necesitan números.

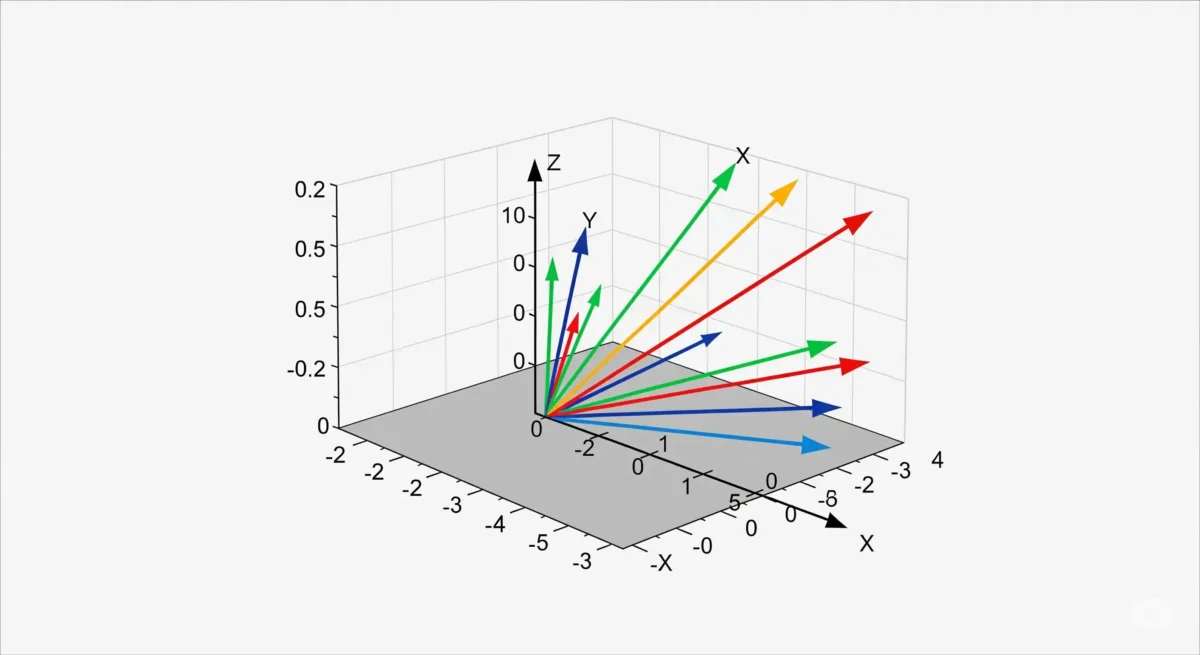

- Definición: Representaciones numéricas (vectores) de palabras, frases o documentos que capturan su significado semántico y contextual.

- Analogía: Piensa en un mapa donde la cercanía entre dos puntos representa la similitud de su significado.

- ¿Cómo se crean? A través de redes neuronales, donde palabras con significados similares tienen embeddings similares.

- 3.4. Vectores: La Columna Vertebral de los Embeddings.

- Definición: Una lista ordenada de números (ej., [0.2,−1.5,3.1,…]).

- Importancia: Son el formato en que se almacenan y procesan los embeddings.

- Espacio Vectorial: Un espacio multidimensional donde los vectores se ubican. La distancia entre vectores indica similitud.

4. Modelos de Lenguaje Grandes (LLMs): La Nueva Generación de IA Conversacional

- 4.1. ¿Qué son los LLMs?

- Definición: Son modelos de Machine Learning (generalmente redes neuronales profundas, transformadores) entrenados con cantidades masivas de datos de texto.

- Objetivo: Generar texto coherente y relevante, responder preguntas, traducir, resumir, etc.

- Ejemplos Famosos: GPT-3, GPT-4, LLaMA, Bard (Gemini).

- 4.2. ¿Cómo “piensan” los LLMs? La Predicción de la Siguiente Palabra.

- No “entienden” como un humano, sino que son expertos en predecir la secuencia más probable de palabras basándose en los patrones que aprendieron de sus vastos datos de entrenamiento.

- El “conocimiento” de un LLM está implícito en las relaciones estadísticas que ha descubierto entre las palabras.

- 4.3. La Ventana de Contexto: La Memoria del LLM.

- Definición: El número limitado de tokens (palabras, subpalabras) que un LLM puede “recordar” o tener en cuenta en una sola interacción o turno conversacional.

- Importancia: Determina la coherencia y la capacidad del modelo para seguir el hilo de una conversación larga o procesar documentos extensos.

- Limitaciones: Si el contexto excede la ventana, el modelo “olvida” el principio de la conversación.

5. Interactuando con la IA: El Arte del Prompting

- 5.1. ¿Qué es un Prompt?

- Definición: La instrucción o pregunta que le das a un modelo de IA (especialmente LLMs) para que genere una respuesta.

- Es tu forma de comunicarte con la IA y guiar su salida.

- 5.2. La Importancia del Prompt Engineering (Ingeniería de Prompts):

- Concepto: El arte y la ciencia de diseñar prompts efectivos para obtener los resultados deseados de un modelo de IA.

- Consejos para buenos prompts:

- Claridad y especificidad: Sé claro en lo que quieres.

- Contexto: Proporciona información relevante.

- Rol: Pídele a la IA que actúe como un experto en un tema.

- Formato: Especifica el formato de salida deseado (ej., lista, párrafo, código).

- Ejemplos (Few-shot learning): Dale ejemplos de lo que esperas.

- Ejemplo:

- Prompt malo: “Escribe sobre perros.”

- Prompt bueno: “Actúa como un veterinario y escribe un breve párrafo explicando los beneficios de la esterilización en perros pequeños, para dueños primerizos.”